皆さん、こんにちは!

最近機械学習エンジニアからDevOpsエンジニアにキャリアチェンジをしつつある渡邊(@move_fastest)です。

月日が流れるのが早く、昨年3月に入社して、早くも1年が経とうとしています。

実は昨年の年末からAWSジャパン様で企画された、「ANGEL Dojo」に会社の若手を代表して参加させて頂いています!

※ANGEL は APN((AWS Partner Network)Next Generation Engineer Leaders の略

2/14(金)に中間発表を終え、ANGEL Dojoも終盤に差し迫ってきたということで、これまで取り組んできたことを振り返ってみたいと思います!

クラウド開発で日本を元気にする ANGEL Dojo!

AWS様公式のHPに「ANGEL Dojo」の定義が書いてあったので引用します。

ANGEL Dojoでは次世代を担うAPNの若手のエンジニアの方々に、擬似プロジェクトを通じてアジャイル、DevOps、モダンなアプリケーション開発などのクラウドネイティブな手法と、様々なInnovationを作ってきたAmazonの文化と考え方を体験いただくことで、お客様にクラウドの価値を100%届けるための基礎的なスキルを実践を通して身につけていただきます。参加者の皆様はここで培ったスキルと、各パートナーの皆様がお持ちのそれぞれの強みを活かすことでお客様のビジネスを成功に導き、日本のITや経済をさらに成長させる主役、すなわち「APN Next Generation Engineer Leader」になっていただきます。

要するに、AWS様主催の疑似プロジェクトを通して、クラウド開発力とAmazonの文化を学び、ビジネスで日本を元気にしよう! という企画です。

IT経験1-3年以内の人が対象で、3月初旬に最終発表があります!

ちなみに、ANGEL Dojoの企画が始まるきっかけとなったのは、ある日AWSのマネージャーの方が「日本を元気にしたい!」と言い出したのがきっかけだそうです。

「日本を元気にしたい!」と思うだけではなく、それを実際に企画してしまう行動力、そしてそれを許容する柔軟な組織文化が凄いなぁと思いつつ、感謝の気持ちでいっぱいです。

↓詳しくはこちらをご覧下さい↓

「日本を元気にする」APN Next Generation Engineer Leaders(ANGEL) Dojo のご紹介

知らないことだらけの疑似プロジェクト

サービスの企画から検討するのって楽しい、けど、難しい

年明け(1/6(月))からプロジェクトがスタートし、最初の2週間は企画のフェーズでした。

"Working Backwards"(逆向き解決法)と呼ばれる、Amazonが実際にサービス企画をする際に使用するフレームワークで、お客様を起点にサービスの企画を行い、それをもとにPR(プレスリリース)を作成しました。

一からサービスを企画するのは想像していたよりもずっと難しかったです。

気づくといつも「お客様が必要としているもの」ではなく、「自分達が作りたいもの」になってしまっていました笑。

そんなとき、「自分達が企画するサービスは、本当にお客様が求めているものなのか?」 この問いに何回も立ち返り、メンバ同士で議論することで、徐々に、お客様が求めているもの(課題)やそれを解決するサービスに対する理解が深まりました。

結果として、(多くの時間を費やしたお陰もあり、)サービス内容をブラッシュアップすることができたので、非常に合理的なフレームワークだと感じました。

何を作っているかというと、みなさんの会社でも(おそらく)非効率になりがちな会議を効率化するためのサービスです。詳細は今後のお楽しみに♪

良いサービスを開発したい!

1月終盤より、企画したサービスをもとに、アーキテクチャを考え、実装に入ります。

しかし、自分達で考えたアーキテクチャ、DBスキーマ、レポジトリがナンセンスで、何度もリファクタをする羽目に・・・

普段のプロジェクトでは上司が設計してくれている部分なので、改めて無駄がなく整理されたアーキテクチャを考えてくれている上司の偉大さが身に染みました。ありがたや・・・

本当は1月中にMVP(Minimum Viable Product)を社内リリースして運用してみたかったのですが、間に合わず断念。

その後も中間発表の準備に加え、セキュリティ観点での課題も見つかり、まだ社内リリースができていません。

早く社内にリリースして実際に使ってもらいたいです。

ということで、現在も機能の作成は続けています、正直トライ&エラーの繰り返しですが、より良いサービスを作りたいという思いが強いので、とても楽しい時間です!

中間発表で1位に選んで頂きました!

最終発表は3月初旬ですが、2/14(金)に中間発表がありました!

発表は午後からだったのですが、発表で使用するデモ動画、発表資料の修正を当日のランチ頃まで行っており、かなりドタバタしてしまいました。

中間発表では、全15チームが揃って発表することもあり、そこで初めて他の参加企業が作ろうとしているサービスを知ることができました。

どの企業もWorking Backwardsでお客様が日頃感じる不満から逆算した、サービス内容だったので、聞いていて素直に、「このサービス欲しいなぁ」、「このサービスが実在したら、日頃困らなくなるなぁ」と納得させられるものがほとんどでした。

私達の発表では、実際に利用してもらうシーンを想定してもらうため、作成したサービスを使用したデモ動画を紹介しました。

苦労して作成したデモ動画が好評だったこともあり、ありがたいことに中間発表では参加者投票で1位を取ることができました。

ただ、どのチームのサービスも魅力的だったので、本番発表まで残すところ2週間弱、より良いサービスを作れるよう頑張ります!

周りの方々のサポートに感謝

このチャレンジをするにあたって、多くの方々のサポートがあります。

AWS様は、週2~3回の講義、ハンズオンなど多くの企画も実施して頂いており、とても勉強になっています。また、クラウド開発のアーキテクチャやお客様視点で考えるためのコツなど、アドバイスやレビューを何度も実施してもらっており、とても助かっています。本当にありがとうございます!

さらに、この企画は1チーム5人での参加が基本となっていますが、1社で5人というのはなかなか難しく「混合チームとして参加」という案で考えていた中、「どうせやるなら5人でやった方が良い」と送り出してくれた社長・副社長には感謝です!

このように、年始から始動し、色々な方のサポートの元開発を進めているサービスなので、世の中に役立つものとして今後公開できるようにしたいと考えています!

そして、最終発表では1位になって周りで支えてくれた人に恩返しがしたいので、最終発表の3/6(金)に向けて、ラストスパートをかけていきます!

(実は、上位のチームは AWS Partner Summit Tokyo で発表する機会を頂けるので、それもモチベーションになっています)

最終発表の結果もこのブログにて報告するつもりなので、みなさん、お楽しみに!!

Acroquest Technologyでは、キャリア採用を行っています。

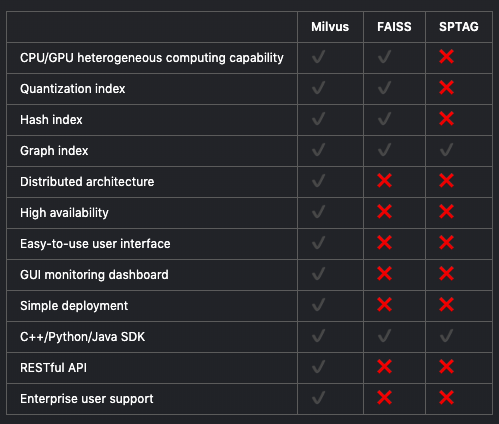

- ディープラーニング等を使った自然言語/画像/音声/動画解析の研究開発

- Elasticsearch等を使ったデータ収集/分析/可視化

- マイクロサービス、DevOps、最新のOSSを利用する開発プロジェクト

- 書籍・雑誌等の執筆や、社内外での技術の発信・共有によるエンジニアとしての成長

少しでも上記に興味を持たれた方は、是非以下のページをご覧ください。

Java/PythonでモダンなWeb開発をしたいエンジニアWanted! - Wantedlywww.wantedly.com