こんにちは。

@shin0higuchiです😊

先日Elastic Stack 5.5.0がリリースされました。

この記事ではKIbanaに追加された新機能をピックアップして紹介します。

(5.5.0ではX-Pack Machine Learningの正式リリースとなりましたが、そちらは@tereka114の別記事にて紹介しています)

この記事で紹介する機能

- Filter機能の強化

- Grok Debugger

- 新しいVisualization(Region Map, Gauge, Goal)

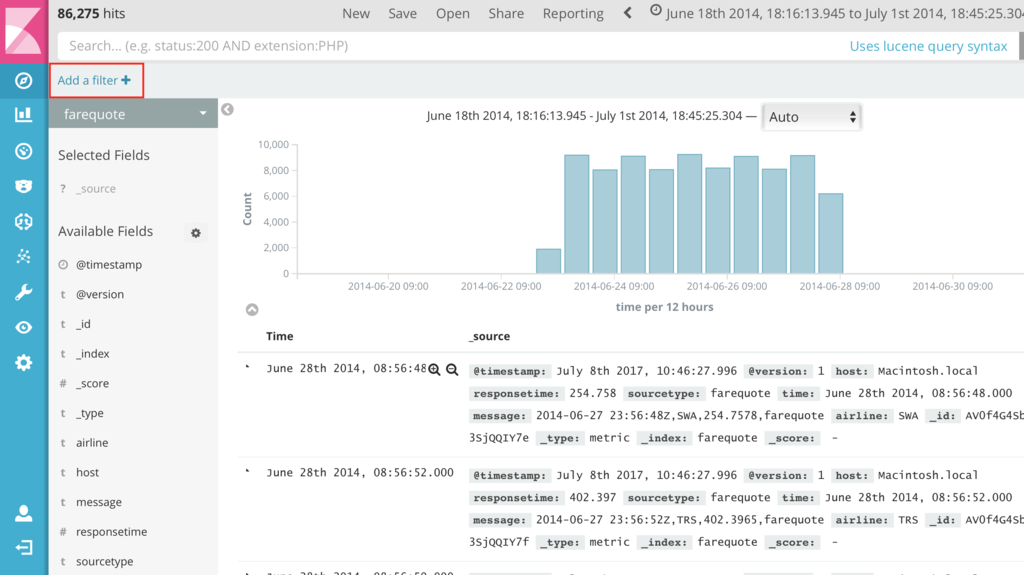

Filter機能の強化

DiscoverやDashboard上で絞り込みを行いたい場合、今まではクエリを自分で入力する必要がありました。

今後はクリックだけで全て操作できるようになります。

非エンジニアのユーザーにとっては非常に嬉しいですね。

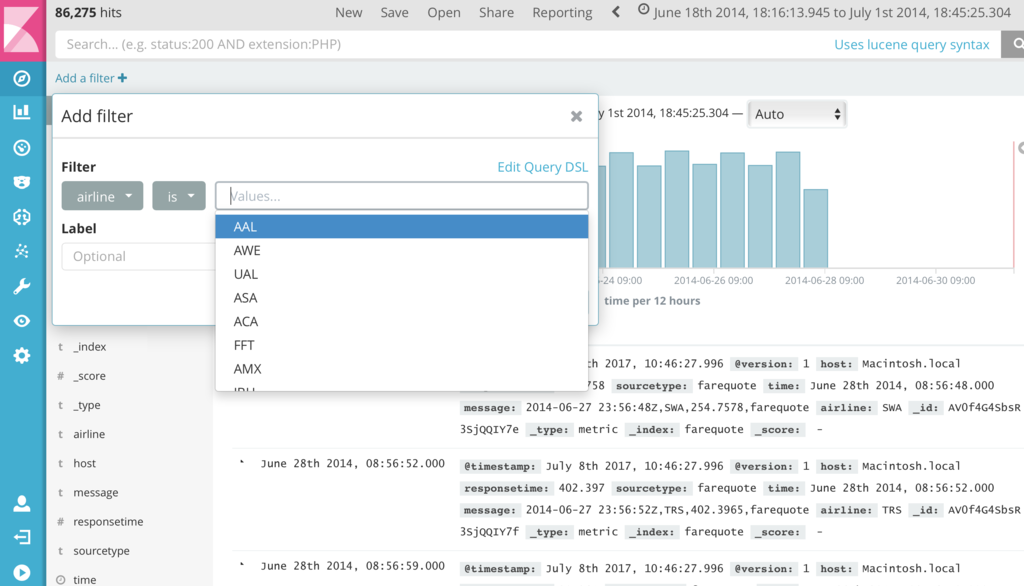

画面左上のあたりに、"Add a filter"という文字が見えると思います。

それをクリックするとfilterが追加できます。

まずはfilter対象のフィールドを選択して...

条件を選びます。

これだけでairlineの値が"AAL"のデータのみが表示されるようにするfilterが作成できました。

これまでは、絞り込むための"フィールド名"を確認してからクエリを書く必要があったので、そういった面でも使いやすくなったと思います😊

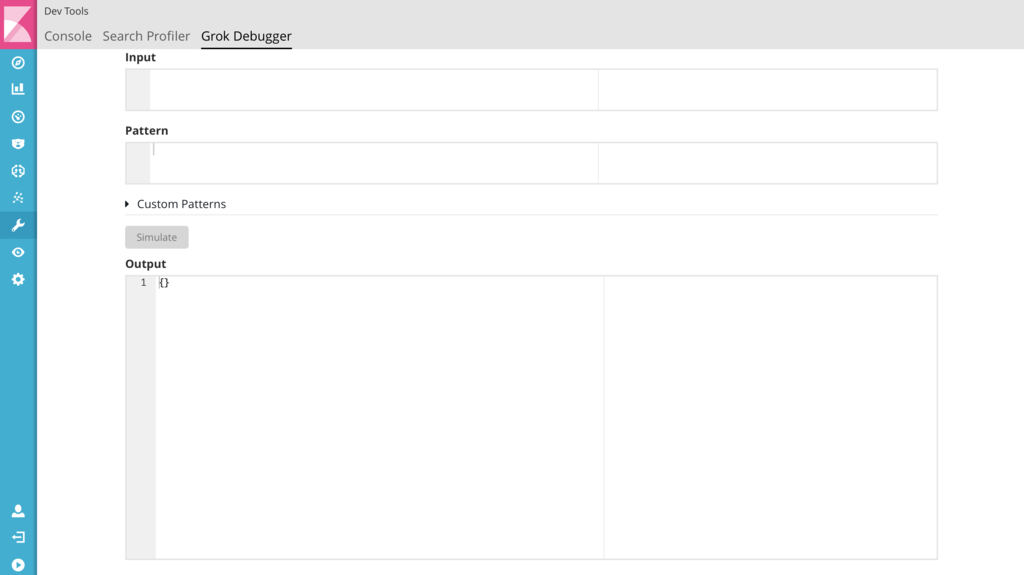

Grok Debugger

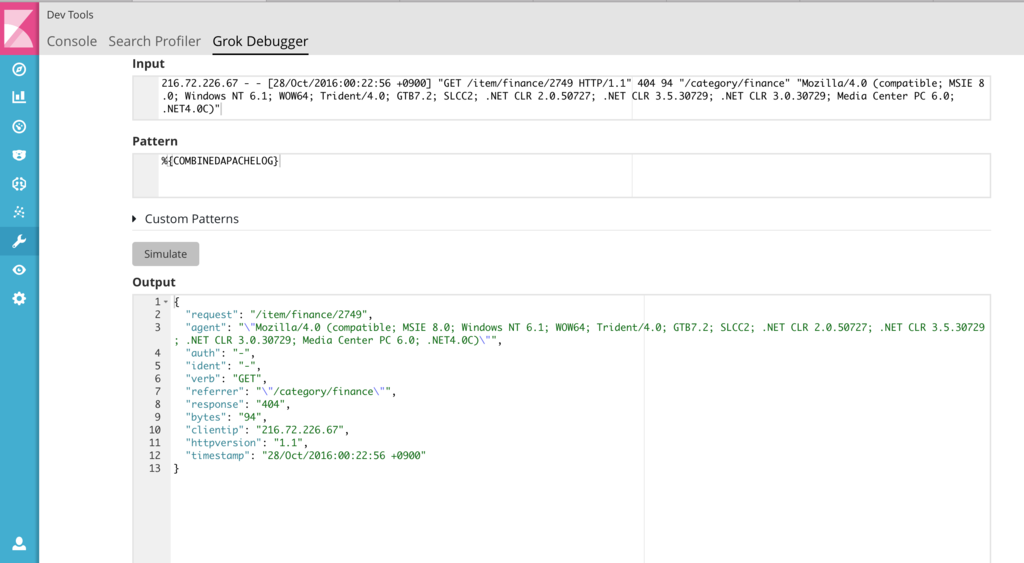

この機能は、Logstashやingest pipelineのgrokを書く助けとなる機能です。

ログの形式に合わせてmatch patternを記述する必要があるわけですが、Grok Debuggerを使えば、

Logstashなどを実行して確認しなくても、Kibana上で先に結果を見ることができます。

(https://grokdebug.herokuapp.comがKibanaに組み込まれた形です)

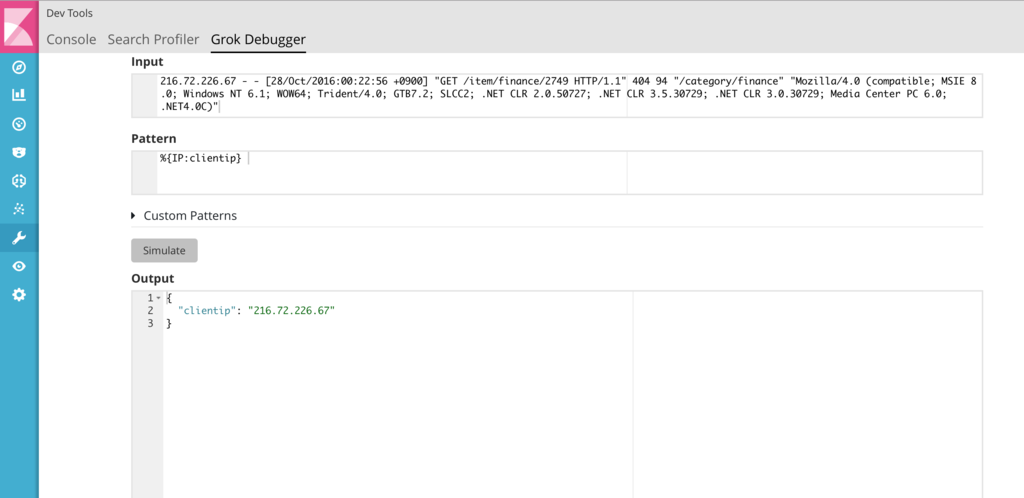

X-Packをインストールしてあれば、このようにDevToolsの中にGrok Debuggerが入ります。

実際の入力となるログをinputに書いておけば、

記述したpatternに応じて結果を表示してくれます。

上手くいきました。

Logstashなどで動かす前にはこれで確認するのが速いですね

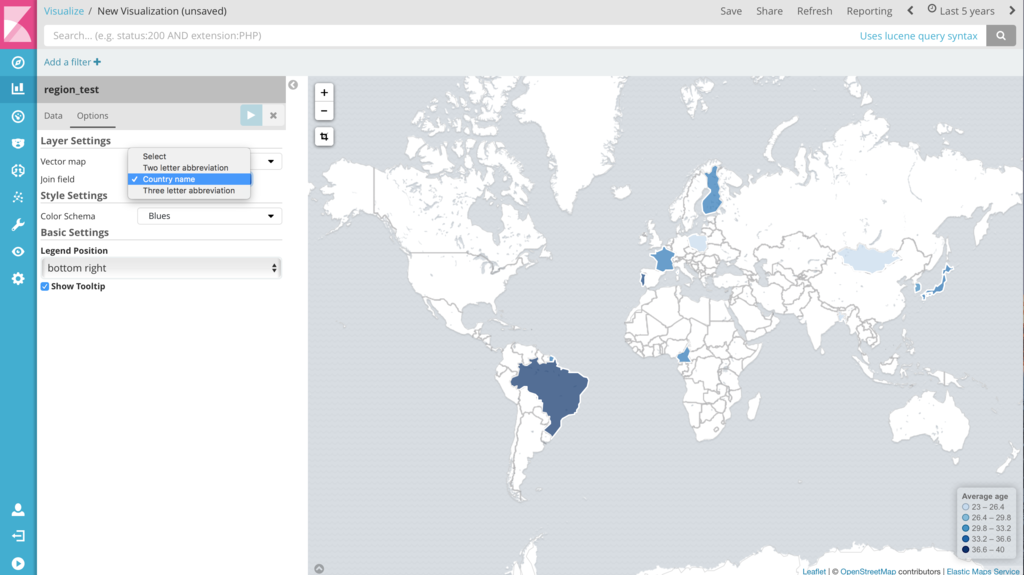

Region Map Visualization

Visualizationの作成画面を見るとRegion Mapが追加されていることがわかります。

Region Mapは、緯度経度の情報が無くても、国名などで地図上にデータを表示することができます。

たとえば下の画像例のように、あるサービス利用者の平均年齢を表示することなどができます。

色を変えたりもできます

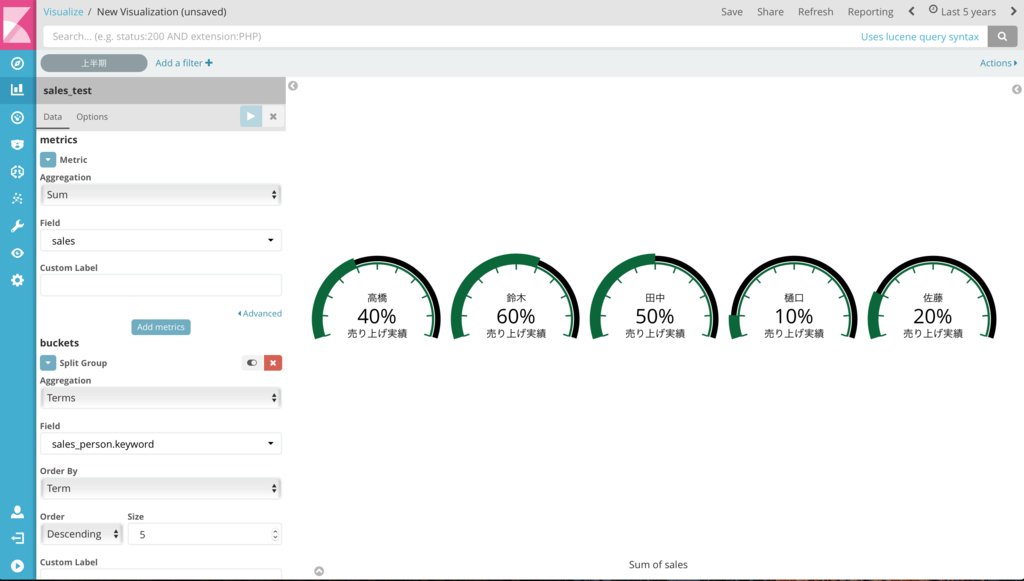

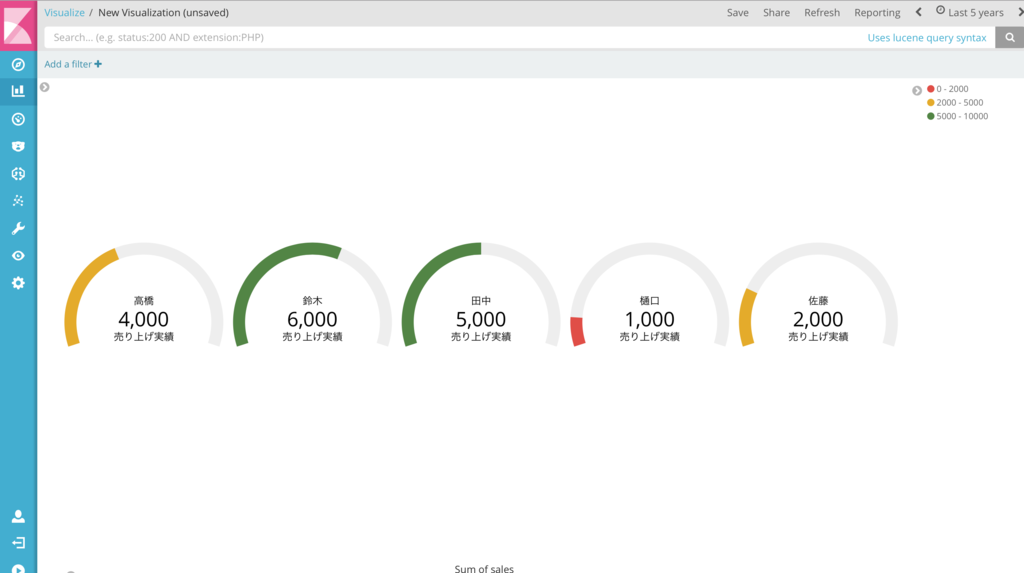

Goal,Gauge Visualization

Goal, Gaugeに相当するものは、もともとVisual Builderの一機能として提供されていましたが、

独立したvisualizationになったことで、設定がわかりやすくなりました。

このvisualizationを使うと、

たとえばセールス部門の売り上げ目標に対して、実績がどの程度あるかなどを可視化できます。

"Goal"で可視化してみるとこんな感じです。

Gaugeは機能的にはGoalとほとんど同じですが、値の範囲を自分で区切って、色をつけることができます。

(可視化したデータは架空の人物および売り上げ実績です)

まとめ

バージョン5.5.0では、使いやすさの向上や表現力の強化が良い感じでした。

ますます使いやすくなることを期待しましょう。

今後も新情報を発信していきますので、よろしくお願いします!

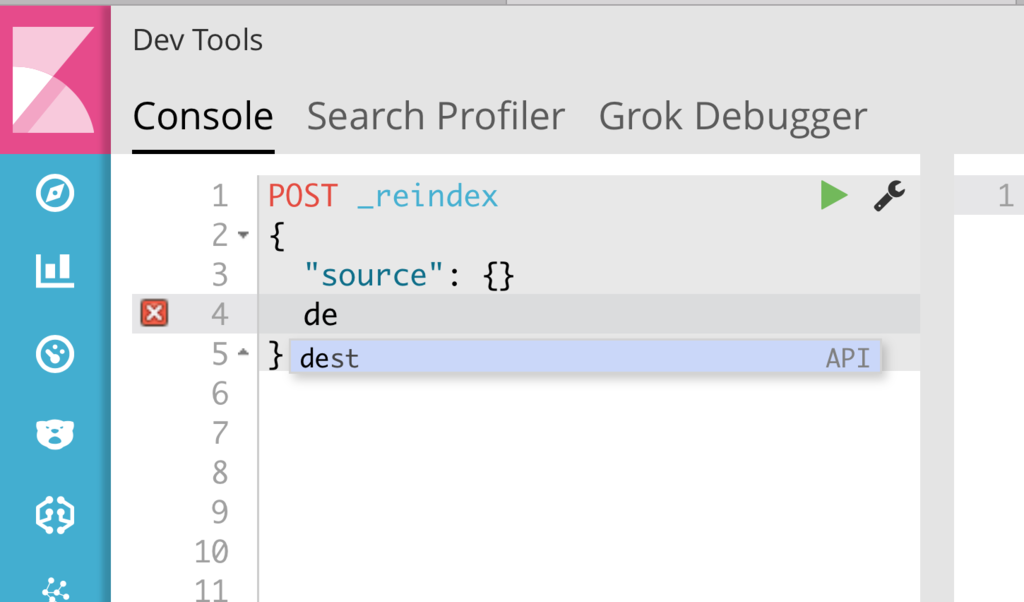

おまけ

(実は、個人的に嬉しかったのは、Consoleでreindexを補完してくれるようになったことです😇)

Acroquest Technologyでは、キャリア採用を行っています。

- ビッグデータ(Hadoop/Spark、NoSQL)、データ分析(Elasticsearch、Python関連)、Web開発(SpringCloud/SpringBoot、AngularJS)といった最新のOSSを利用する開発プロジェクトに関わりたい。

- マイクロサービス、DevOpsなどの技術を使ったり、データ分析、機械学習などのスキルを活かしたい。

- 社会貢献性の高いプロジェクトや、顧客の価値を創造するようなプロジェクトで、提案からリリースまで携わりたい。

- 書籍・雑誌等の執筆や、対外的な勉強会の開催・参加を通した技術の発信、社内勉強会での技術情報共有により、エンジニアとして成長したい。

少しでも上記に興味を持たれた方は、是非以下のページをご覧ください。Elasticsearchを仕事で使いこみたいデータ分析エンジニア募集中! - Acroquest Technology株式会社のエンジニア中途・インターンシップ・契約・委託の求人 - Wantedlywww.wantedly.com