皆さんこんにちは

機械学習チームYAMALEXの@tereka114です。

YAMALEXは Acroquest 社内で発足した、会社の未来の技術を創る、機械学習がメインテーマのデータサイエンスチームです。

(詳細はリンク先をご覧ください。)

KDD主催のコンペティションKDDCupで入賞したことより、昨年に引き続き、KDDに参加しましたのでそのレポートを記載させていただきます。

今年はスペイン・バルセロナでの開催だったため、ヨーロッパへ初渡航でした。楽しかったです!

※昨年のレポートはこちら

acro-engineer.hatenablog.com

KDD2024

KDDは正式名称、30th ACM SIGKDD CONFERENCE ON KNOWLEDGE DISCOVERY AND DATA MININGです。

8月25日(日)〜29日(木)主なテーマとしてデータマイニングを扱うカンファレンスです。

今回の会議としてはKeyNote3本、各セッションへの参加、Workshop/Tutorialへの参加など盛りだくさんでした。

昨年と変わらず、リモートでの参加はできず、基本現地への参加になるものでした。

KDDには主に、SIGKDD Conference(本会議)、KeyNote、Workshop/Tutorialに加え、各論文を説明するセッションやポスター発表から構成されています。

今年のセッション部は10ほどのテーマごとに常時開催されていて、合計で約180のセッションが開かれ、非常に盛り上がりました。

また、KDDで開催されるコンペティションのKDDCupはテーマを変えて毎年開催されており、結果はKDDCupのWorkshopで発表されます。

今年はアカデミックな論文の関係性を示すグラフの問題をLLMで解く、RAGを利用したもの、オンラインショッピングのAnswerを回答するネタがあり、私達はオンラインショッピングに参加していました。

Opening

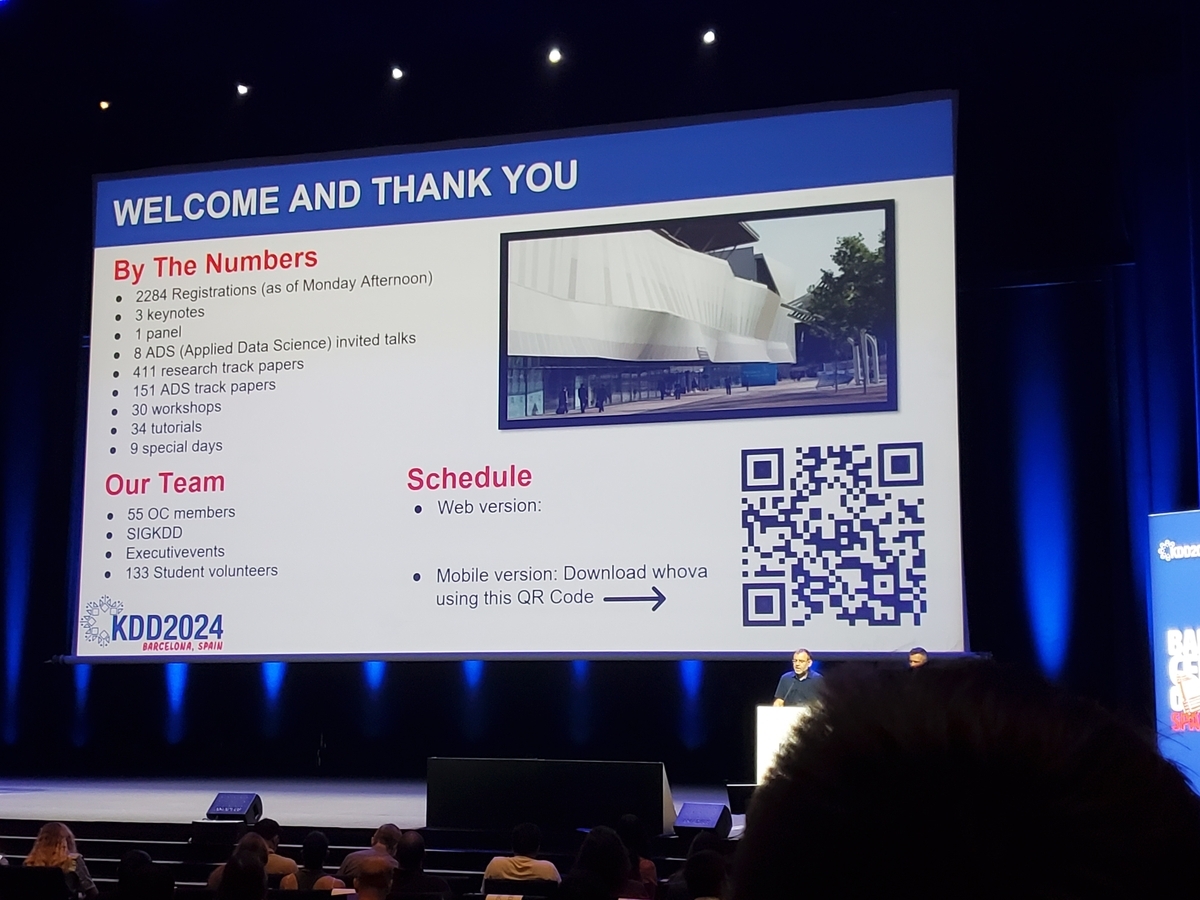

今年のKDDのOpening Sessionです。

参加者は昨年と同じ程度の2300人の参加でした。

同じタイミングでBest Paperをはじめとした賞の紹介もありました。

Best Paperは

Tutorial/Workshop

LLMに関連する研究が非常に早いスピードで進化していますので、そのキャッチアップのために参加しました。

LLMで最も有名な精度向上方法であるRAGを利用したOverview、また、LLMを利用した時系列や空間/時間に関する基盤モデル構築の話もあり、LLMで実施されていることが他の分野にも進出している様がありました。

RAG Meets LLMs: Towards RetrievalAugmented Large Language Models

LLM関係で最も有名な技術としてRAG(Retrieval Augmented Generation)があります。

RAGに関係する論文も多くこの1年で発表されたので、RAGに関する技術内容を体系立てて、一般的な課題や関連手法に関する説明がありました。

私自身、1年間RAGに関連する技術が高速に発展したと感じていますので、このワークショップでその技術の整理ができました。

また、LLMを利用した具体的なアプリケーションにおける用途も説明されているため、どのようなものに利用できるかアイデアも膨らませられ、面白かったです。

※ワークショップページはこちら、ページにはスライドもあるのでおすすめです。

advanced-recommender-systems.github.io

The 10th Mining and Learning from Time Series Workshop: From Classical Method to LLMs

このワークショップでは、古典的な手法からLLMでの時系列モデリング話まで含まれていました。

LLMといえば、チャットサービスかRAGの分野を一般的に頭に思い浮かべますが、時系列予測にLLMを応用する論文が紹介されていました。

例えば、次の論文にあるLLMの一つであるT5と人工データを利用して時系列データを事前学習させるとZeroshotで新しいデータに対しても時系列推論ができるのは面白かったです。

更に、このモデルを使ってより特定のデータをFinetuneして精度を向上させることも可能です。

時系列に対してトークンを生成すると、そもそも通常の学習では学べるはずの数値の上下関係(例:0.2 > 0.1)が学習できないので若干の違和感を感じますが、データの量と事前学習がここまでの効果を発揮するのは驚きです。

また、こちらの論文のモデルは公開されているため、すぐに利用できるので試す機会があれば、利用しようと思っています。

※ワークショップページはこちら

kdd-milets.github.io

KDDCup2024

私達がKDDCup2024で参加した今年の問題はAmazonのオンラインショッピングに関する問題を解くスコアを競うものでした。

それぞれのテーマで分割されているTrack1〜Track4の独立した問題セットとすべてを一つのモデルで解くTrack5がありました。

詳しくは次の公式サイトをご確認ください。

また、本コンペティションには当社のチームも出場し、入賞しました。

本KDDCupのWorkshopでは上位チームの解法が話されていました。

個人的な学びポイントは次のとおりです。

1. 基盤モデルの選定が最も重要、案の定パラメータが大きなモデルが勝ちやすい。

2. 推論環境がT4x4の場合、AWQによりパラメータを削減することで72Bでも高速な推論(推論時間)が可能である。

3. vllmによる高速推論、huggingfaceよりも遥かに高速で便利である。

KDD Annual Celebration

毎年、開催されているKDDのパーティーに参加しました。

今年のカンファレンスの総合情報、スポンサーによるプレゼン、来年のカンファレンスの会場(カナダ・トロント)の紹介がありました。

その後は立食パーティーになりますので、歩きながら他の参加者とも話していました。

その他

もう少しで建設が完了するサグラダ・ファミリアやカタルーニャ歴史博物館にも行きました。

特にサグラダ・ファミリアに入るには予約が必要です。なかなか取りづらいので、サグラダ・ファミリア公式アプリによる事前予約がオススメです。

総括

LLM2年目ともあり、LLMの研究も少し方向性が変わってきました。

1. 昨年はLLMとは?といった基本的なものでしたが、RAGや既存モデルを利用した応用が増えた。

2. LLMのトラックが新設されて独立しており、関連する多くの論文発表があった。

3. LLMを応用した他分野への基盤モデルの作成

最後に

KDD2024はご飯、観光先の多いスペインともあり、立地も含め、総合的に非常に満足度の高い学会でした。

学会では、特にLLMが多く変わらず注目度が高いと感じました。

来年もKDDCupで勝って参加したいと思います。

Acroquest Technologyでは、キャリア採用を行っています。

- Azure OpenAI/Amazon Bedrock等を使った生成AIソリューションの開発

- ディープラーニング等を使った自然言語/画像/音声/動画解析の研究開発

- マイクロサービス、DevOps、最新のOSSやクラウドサービスを利用する開発プロジェクト

- 書籍・雑誌等の執筆や、社内外での技術の発信・共有によるエンジニアとしての成長

少しでも上記に興味を持たれた方は、是非以下のページをご覧ください。

www.wantedly.com